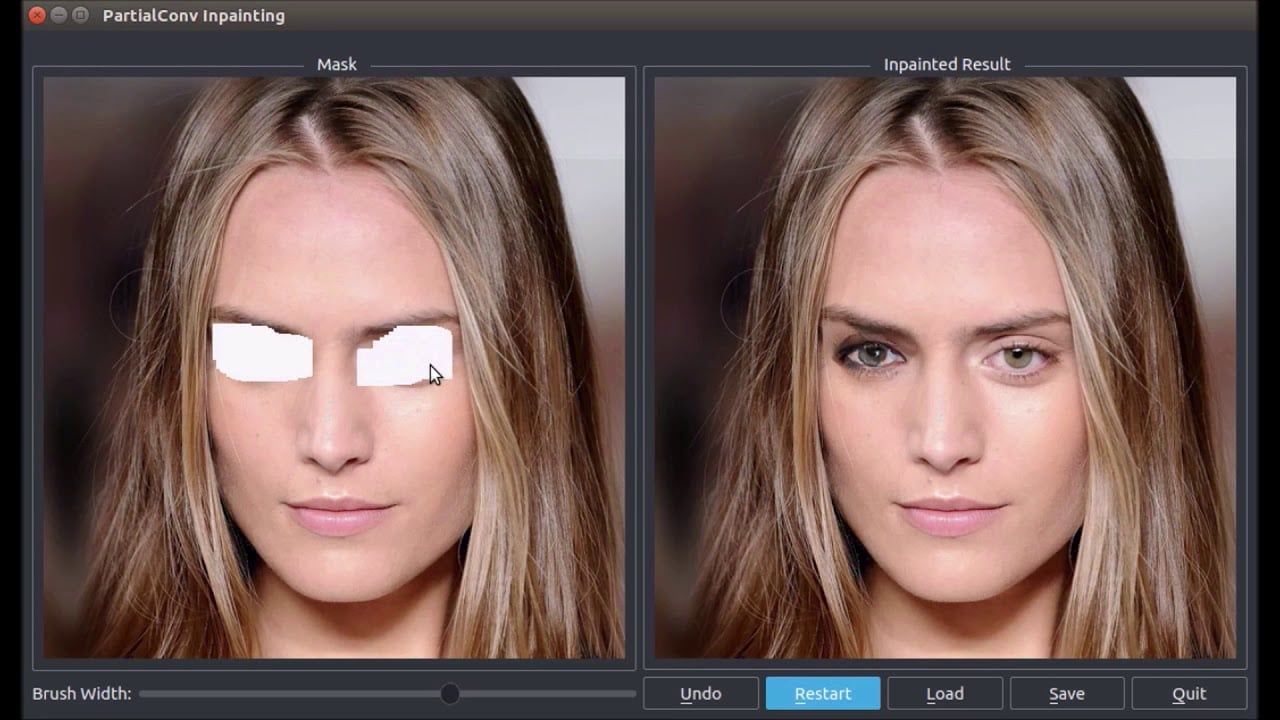

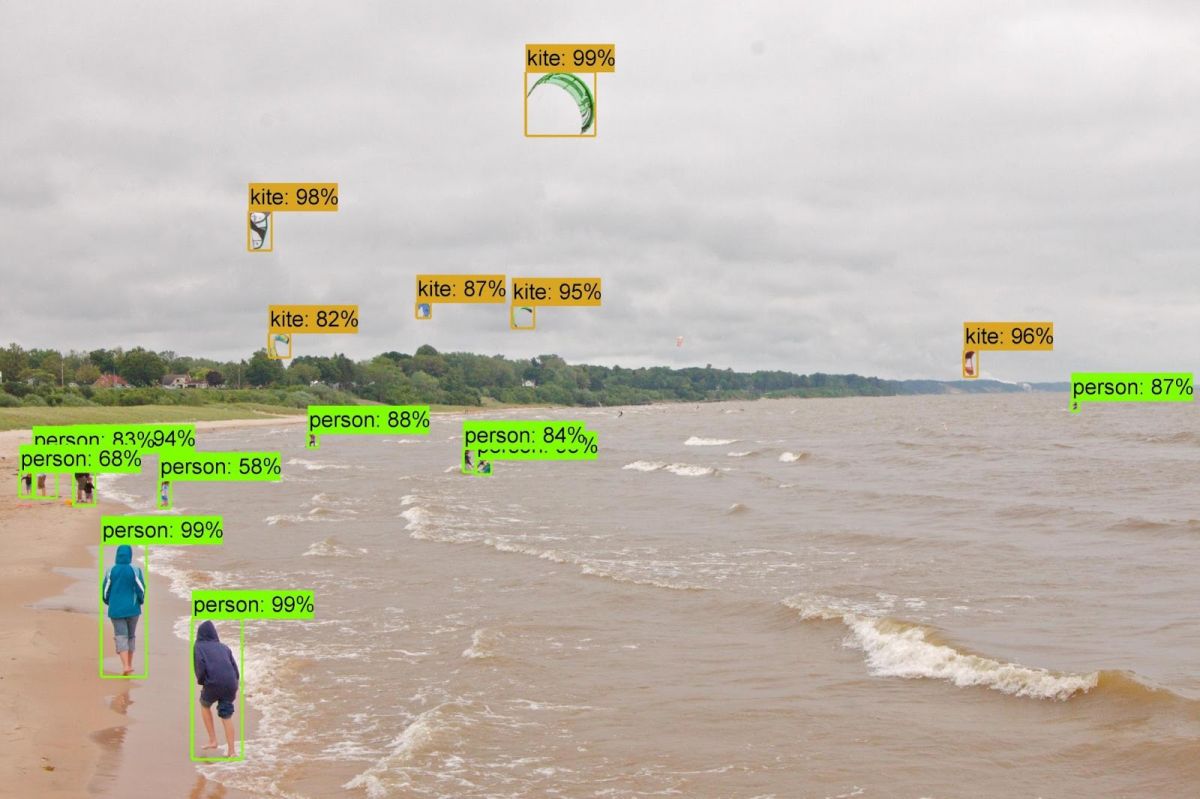

Makine öğrenme ve yapay zeka kavramları insanlığın teknoloji ile olan ilişkisindeki güncel sıçrama tahtası niteliğinde. Akademisyenler, araştırmacılar ve teknoloji şirketleri sürekli olarak bu alanda çalışmalar yaparak ilerlemelerini paylaşıyorlar. Google, TensorFlow’u 4 sene önce herkesin erişimine açmış, 2016’da AI Experiments projesiyle yapay zeka deneylerini desteklemiş, 2017’de AutoML’i tanıtmıştı. Microsoft 2015’te fotoğraflardaki insanların yüz hallerinden duygu durumlarını analiz edebiliyordu. Nvidia da fotoğraflardaki silinmiş alanları makine öğrenme ile tamamlayabiliyor. MIT ise Shelly isimli botuyla yapay zekanın korkularına inmişti.

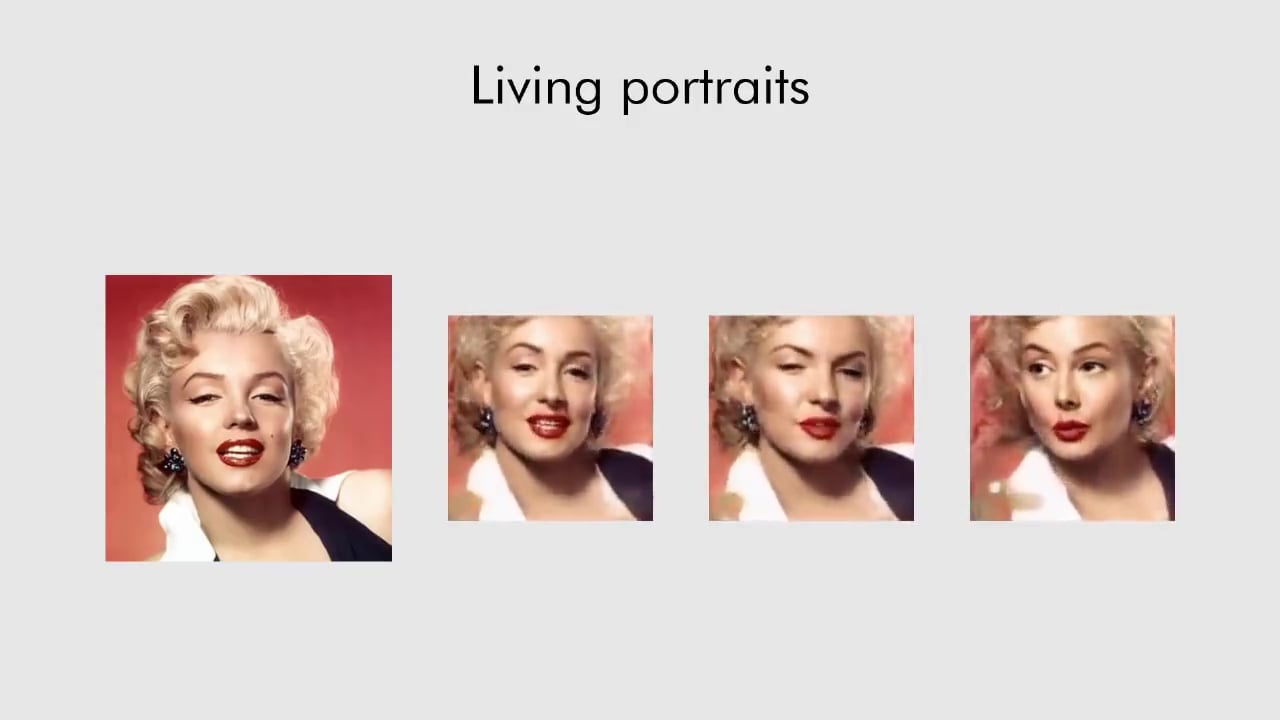

Samsung AI Center çatısı altındaki Egor Zakharov, Aliaksandra Shysheya, Egor Burkov ve Victor Lempitsky tarafından yürütülen proje, tek bir fotoğraf üzerinden kişinin yüz hatlarını çıkarıyor ve anında canlandırılabilir hale getiriyor. Yapılan animasyon sadece gerçek kişiler ve fotoğraflarla da sınırlı kalmayıp resimleri de kapsıyor. Few-Shot Adversarial Learning of Realistic Neural Talking Head Models başlıklı makale ile paylaşılan ilerlemeler kimi açılardan hali hazırda olan gelişmeler gibi görülse de birkaç detay ile ayrışmayı başarıyor.

Another great paper from Samsung AI lab! @egorzakharovdl et al. animate heads using only few shots of target person (or even 1 shot). Keypoints, adaptive instance norms and GANs, no 3D face modelling at all.

▶️ https://t.co/Xk5D4WccpD

? https://t.co/SxnVfY72TT pic.twitter.com/GjVrJbejT0— Dmitry Ulyanov (@DmitryUlyanovML) May 22, 2019

Tek bir fotoğrafla Mona Lisa’yı canlandırmak

Geliştirilen bu yeni method ile yüz hatları kaynak veri olarak alınan yüz ve kişiden hedef yüze aktarılıyor. Hedef yüz de paylaşılan yüz verisi ile kaynak kişi ne yapıyorsa aynısını kopyalıyor. Bir görseli alarak başka bir görsel üzerine uygulamak ve sentetik imgeleme yaratmak günümüz yapay zeka alanının adeta kum havuzu gibi. Deepdream olarak çıkan eserler benzer bir prensiple çalışıyor. Ve Deepfakes isimli kategori altında kopyalanan insan yüzleri de benzerlikler taşıyor. Ancak tüm bu mevcut yöntemlerle Samsung AI Center araştırmacılarının ayrıştığı nokta gereken veri miktarı. Geçmiştekiler yöntemlerde bir yüzün kopyalanabilmesi için çok fazla veriye ihtiyaç duyuyordu. Yüz modelinin çıkması ve taklit edilmesi için yaklaşık olarak bir veya iki dakikalık video gerekiyordu.

Bu yeni method ile birlikte tek bir fotoğraf bile hedef ile kaynak arasında bir köprü kurularak uyarlama yapılabiliyor. Ancak 8 selfie olduğunda yazılımın başarısı artıyor. Kaynak olarak fotoğraf miktarı 32’ye çıktığında ise yapay zeka çok daha başarılı uyarlamalar yapıyor. Video, selfie gibi basit ve yalın birkaç kaynak kullanarak yapılan bu uyarlamaların başarısını da yayınladıkları videodan görebilirsiniz.

Görsel: YouTube