GPT-4o, insan-bilgisayar etkileşimine benzersiz bir doğallık katmak üzere atılan dev bir adım niteliğinde. Anlık diyaloglar, anlık video analizi, anlık çeviri ve çok daha fazlasıyla büyük bir fark yaratan bu model; yakın gelecekte yapay zekâ teknolojisinin neleri getireceği konusunda öngörüleri – ve biraz da endişeleri – güçlendiriyor.

GPT-4o’un yeteneklerini ve bunun günlük yaşama nasıl yansıyacağını şöyle listelememiz mümkün:

- Bellek Yeteneği: Kullanıcılarla yapılan önceki görüşmelerden öğrenme kabiliyeti.

- Gerçek Zamanlı Çeviri: Anlık çeviri yapabilme yeteneği, 50 farklı dilde çeviri desteği sağlaması.

- Matematik Problemlerini Konuşarak Çözme / Özel Öğretmenlik: Kullanıcılara matematik problemlerini akıcı bir şekilde anlatarak bu problemleri çözme yeteneği.

- Konuşma Yeteneği: Sesli iletişim yeteneğiyle, gerçek bir insanla konuşuyormuş hissiyatı yaratması. Ses tonlamaları arasındaki farkı ayırt edebilmesi.

- Çoklu Ortam Analizi: Görselleri ve metni analiz ederek, metin ve görsel veriler arasında ilişki kurabilme yeteneği.

Bu yetenekler, GPT-4o’nun kullanıcılarla etkileşim kurma ve çeşitli görevleri yerine getirme konusundaki geniş yelpazesini temsil ediyor. Model, deneyimlerine dayalı öğrenmeyi sürdürerek kendini geliştirebilecek.

GPT-4o, dün OpenAI tarafından YouTube üzerinden yapılan bir canlı yayınla tanıtıldı. Bu yayında, bu yetenekleri nasıl sergilediğini görebilirsiniz:

GPT4o, tüm ChatGPT kullanıcıları için ücretsiz olacak ancak şirket, insanların bunu ücretsiz olarak ne zaman kullanabileceği konusunda henüz net bir açıklama yapmadı. CEO Sam Altman’ın yaptığı tek açıklama “yeni ses modunun önümüzdeki haftalarda plus kullanıcıları için yayınlanacağı” oldu. Bu konudaki detayları haberin finalindeki “Model kullanılabilirliği” bölümünde görebilirsiniz.

Say hello to GPT-4o, our new flagship model which can reason across audio, vision, and text in real time: https://t.co/MYHZB79UqN

Text and image input rolling out today in API and ChatGPT with voice and video in the coming weeks. pic.twitter.com/uuthKZyzYx

— OpenAI (@OpenAI) May 13, 2024

Peki GPT-4o’nun yetenekleri, hangi yeniliklere dayanıyor? Gelin OpenAI tarafından yapılan teknik açıklamalara birlikte göz atalım…

GPT4o, GPT-4’un zeka seviyesinde ama ondan çok daha hızlı

GPT-4o; herhangi bir metin, ses ve görüntü kombinasyonunu girdi olarak kabul ediyor ve herhangi bir metin, ses ve görüntü çıktısı kombinasyonunu üretebiliyor. Ses girişlerine 232 milisaniye kadar kısa bir sürede yanıt verebiliyor. Bu süre, bir diyalog esnasında karşınızdaki insanın tepki verme süresine çok yakın. Dolayısıyla iki insan arasındaki diyaloğa çok benzer bir deneyim yaratıyor.

Dog meets GPT-4o pic.twitter.com/5C0hlYq5ws

— OpenAI (@OpenAI) May 13, 2024

GPT-4o’dan önce, Ses Modu kullanılarak ortalama 2,8 saniye (GPT-3.5) ve 5,4 saniye (GPT-4) gecikmelerle ChatGPT ile diyalog kurulabiliyordu. GPT-4 ses tonunu, birden fazla konuşmacıyı veya arka plan seslerini doğrudan gözlemleyemiyordu. Ayrıca kahkaha, şarkı söyleme veya duygu ifade etme çıktısı veremiyordu. Bunun nedeni; üç ayrı modelden oluşan bir işlem hattına sahip olmasıydı. Bir model, sesi metne dönüştürüyordu; bir diğeri metnin çıktısını veriyordu ve üçüncü bir basit model, bu metni tekrar sese dönüştürüyordu. Bu süreç, ana zeka kaynağı olan GPT-4’ün çok fazla bilgi kaybettiği anlamına geliyordu. GPT-4o ile metin, görüntü ve ses genelinde uçtan uca tek bir model devrede. Bu tüm giriş ve çıkışların aynı sinir ağı tarafından işlendiği anlamına geliyor. Open AI, “GPT-4o, tüm bu yöntemleri birleştiren ilk modelimiz olduğu için, modelin neler yapabileceğini ve limitlerini keşfetmenin henüz sadece yüzeysel bir aşamasındayız.” diyor.

İngilizce ve kodlama içeren metinlerde GPT-4 Turbo performansıyla eşleşen yeni model; İngilizce dışındaki dillerdeki metinlerde de önemli bir üstünlüğe sahip. GPT-4o, mevcut modellerle karşılaştırıldığında özellikle görüntü ve ses anlama konusunda daha iyi. Aynı zamanda API’de çok daha hızlı ve %50 daha ucuz.

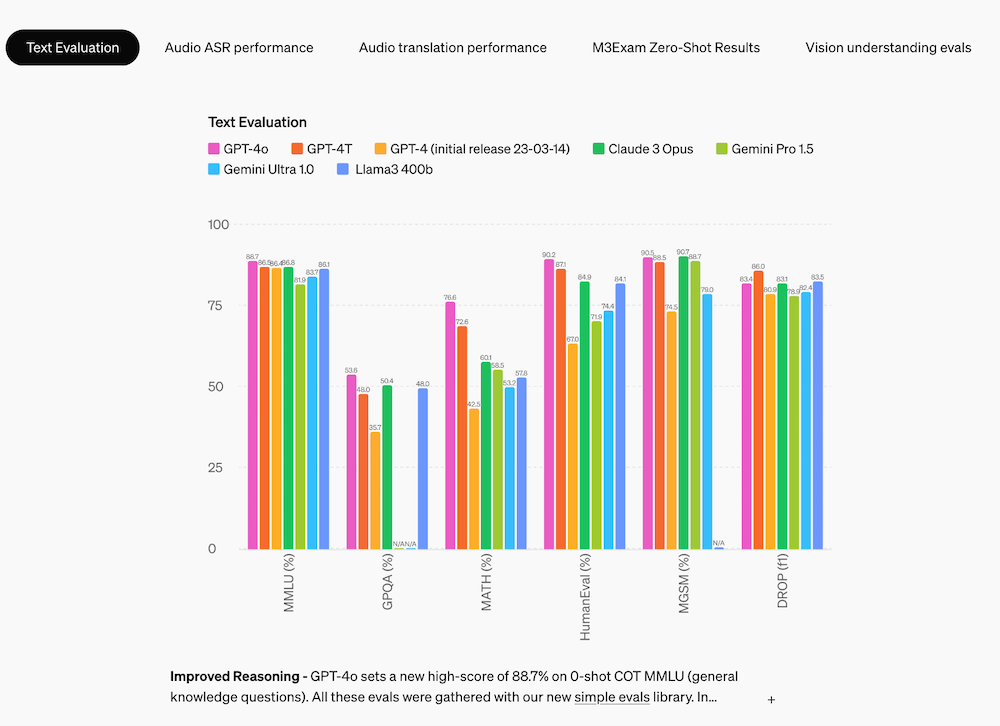

Model değerlendirmeleri

Geleneksel kıyaslamalarla ölçüldüğünde GPT-4o, metin, akıl yürütme ve kodlama zekasında GPT-4 Turbo düzeyinde performansa ulaşırken, çok dillilik, ses ve görüntü yeteneklerinde çıtayı yükselterek yapay zekâ teknolojisini yeni bir seviyeye taşıyor.

Model güvenliği ve sınırlamalar

OpenAI güvenlik konusunda uzun ve detaylı açıklamalarda bulunmuş: “GPT-4o, eğitim verilerinin filtrelenmesi ve eğitim sonrası model davranışının iyileştirilmesi gibi teknikler aracılığıyla, çeşitli yöntemler aracılığıyla tasarım gereği yerleşik güvenliğe sahiptir. Ayrıca ses çıkışlarında siperlik/bariyer sağlamak için yeni güvenlik sistemleri de oluşturduk. GPT-4o’yu Hazırlık Çerçevemize göre ve gönüllü taahhütlerimiz doğrultusunda değerlendirdik. Siber güvenlik, KBRN, ikna ve model özerkliğine ilişkin değerlendirmelerimiz, GPT-4o’nun bu kategorilerin hiçbirinde Orta riskin üzerinde puan almadığını gösteriyor. Bu değerlendirme, model eğitim süreci boyunca bir dizi otomatik ve insan değerlendirmesinin yürütülmesini içeriyordu. Model yeteneklerini daha iyi ortaya çıkarmak için özel ince ayar ve istemleri kullanarak modelin hem güvenlik öncesi azaltma hem de güvenlik sonrası azaltma sürümlerini test ettik.GPT-4o ayrıca, yeni eklenen yöntemlerin getirdiği veya güçlendirdiği riskleri tanımlamak için sosyal psikoloji, önyargı, adalet ve yanlış bilgilendirme gibi alanlarda 70’ten fazla harici uzmanla kapsamlı bir harici kırmızı ekip çalışmasına tabi tutulmuştur. Bu öğrendiklerimizi, GPT-4o ile etkileşimin güvenliğini artırmak amacıyla güvenlik müdahalelerimizi oluşturmak için kullandık. Yeni riskler keşfedildikçe bunları azaltmaya devam edeceğiz.

Açıklama şöyle devam ediyor:

“GPT-4o’nun ses yöntemlerinin çeşitli yeni riskler sunduğunun farkındayız. Bugün, metin ve görüntü girdilerini ve metin çıktılarını kamuya açıklıyoruz. Önümüzdeki haftalarda ve aylarda teknik altyapı, eğitim sonrası kullanılabilirlik ve diğer yöntemlerin piyasaya sürülmesi için gerekli güvenlik üzerinde çalışacağız. Örneğin, lansman sırasında ses çıkışları önceden ayarlanmış seslerden oluşan bir seçkiyle sınırlı olacak ve mevcut güvenlik politikalarımıza uyacaktır. Gelecek sistem kartında GPT-4o’nun tüm yöntemlerini ele alan daha fazla ayrıntıyı paylaşacağız. Modeli test etmemiz ve yinelememiz sonucunda, modelin tüm yöntemlerinde mevcut olan çeşitli sınırlamalar gözlemledik; bunlardan birkaçı aşağıdaki videoda gösterilmiştir. Modeli geliştirmeye devam edebilmemiz için GPT-4 Turbo’nun hâlâ GPT-4o’dan daha iyi performans gösterdiği görevleri belirlemeye yardımcı olacak geri bildirimlerden memnuniyet duyarız.”

Model kullanılabilirliği

“GPT-4o, bu kez pratik kullanılabilirlik yönünde derin öğrenmenin sınırlarını zorlamak için attığımız son adımdır. Son iki yılda yığının her katmanında verimlilik iyileştirmeleri üzerinde çalışarak çok çaba harcadık. Bu araştırmanın ilk meyvesi olarak GPT-4 düzeyindeki bir modeli çok daha geniş bir şekilde kullanılabilir hale getirebildik. GPT-4o’nun yetenekleri yinelemeli olarak kullanıma sunulacaktır (bugünden itibaren genişletilmiş red team erişimiyle birlikte).”

“GPT-4o’nun metin ve görüntü yetenekleri bugün ChatGPT’de kullanıma sunulmaya başlıyor. GPT-4o’yu ücretsiz katmanda ve Plus kullanıcılarının kullanımına 5 kata kadar daha yüksek mesaj limitleriyle sunuyoruz. Önümüzdeki haftalarda ChatGPT Plus’ta GPT-4o alfa sürümüne sahip yeni bir Ses Modu sürümünü kullanıma sunacağız. Geliştiriciler artık GPT-4o’ya API’de bir metin ve görüntü modeli olarak da erişebilir. GPT-4o, GPT-4 Turbo’ya kıyasla 2 kat daha hızlı, yarı fiyatına ve 5 kat daha yüksek hız limitlerine sahip. Önümüzdeki haftalarda GPT-4o’nun yeni ses ve video özelliklerine yönelik desteği API’deki küçük bir grup güvenilir iş ortağına sunmayı planlıyoruz.”

Görsel: OpenAI