Microsoft’ta Yapay Zekâ ve Tasarım Başkan Yardımcısı John Maeda 11 yıldır yayımladığı Design in Tech raporlarıyla, tasarımcıların teknolojiyle nasıl evrildiğini bu sene de SXSW’de ele aldı.

Sunumun başında John Maeda, Alexander Gardner’ın Gettysburg Savaşı sırasında çektiği ve “Home of a Rebel Sharpshooter” (Bir İsyancı Keskin Nişancının Evi) adlı ünlü fotoğrafıyla yapay zekâ çağındaki görsel içeriklerin doğruluğunu sorgulanmasını hatırlattı. Bu fotoğraftan bahsetme nedeni; seneler önce AI hayatımıza girmeden önce bu sahnenin planlanıp çekilmiş olması idi.

Sunumun genelinde AI ile ilgili agent (ajan) çağına giriş yaptığımızı söyledi. Şu anda kullandığımız AI akışlarındaki model yapı ile tek bir komut alma ve yanıt verme şeklinde süreç ilerliyor. Bahsettiği ajan yapı da ise AI hedefe ulaşana kadar çalışmaya devam ediyor, farklı araçlarla sonuca ulaşabiliyor. Ajan yapıdaki AI’lar kendi başına karar alabiliyor ve kendilerini geliştirebiliyorlar. Bunu mümkün kılan şey tek kelimeyle: Döngü. Eğer bir yapay zekâ sisteminde döngü varsa, sürekli olarak öğrenebiliyor, uygulayabiliyor ve daha iyi olabiliyor.

2025 Design in Tech Raporundan Öne Çıkanlar

- Yapay zekâ tasarımcının yerine geçmiyor. Ama tasarım sürecini, kararları alma şeklimizi ve araçlarla ilişkimizi tamamen yeniden şekillendiriyor.

- Yapay zekâ ile denemeler yapmak artık çok daha ucuz ve hızlı.

- “Ajan Çağı” ile artık yapay zekâ sadece tek seferlik cevaplar veren bir sistem değil; bir hedefe ulaşmak için adım adım ilerleyen, araç kullanan ve kendi kararlarını alan yapay zekâ ajanlara dönüşüyor.

- UX (kullanıcı deneyimi), AX’e (agent experience – ajan deneyimi) evriliyor; arayüzler azalıyor, doğrudan yapay zekâ uygulamaları artıyor.

- Yapay zekâ odaklı UX için güven ve kullanılabilirliği artıran yeni tasarım pratikleri oluşuyor.

- Yapay zekâ otomasyonu riskler barındırıyor.

- Yapay zekâ ile desteklenen gelecekte başarılı olmak için insanın uyum yeteneği kritik önemde.

Sunumda Yer Alan Öngörüler:

- UX yerine AX yani Agent Experience hayatımıza giriş yapıyor. Yapay zekâ ajanları arayüzün yeni kullanıcıları artık.

- Artık işi sen yapmıyorsun, işi yapacak zekâyı sen eğitiyorsun!

- Figma, Adobe, Vercel, hatta adı daha yeni duyulan AI girişimleri bile artık “autopilot” moduna geçti. Otomatik tasarım sadece bir hayal değil. Ama bu, senin rolünü silmiyor. Tasarımı sen yapmıyorsun, tasarım yapacak sistemi sen kuruyorsun. AutoDesigner olmanın ilk kuralı bu.

Yeni Nesil AI UX Tasarımı – Temel İlkeler

John Maeda‘nın LinkedIn’de yayımlanan “Yapay Zekâ Geliştiricileri için UX Tasarım Pratikleri” kursundan notlar:

- Kullanıcıya neyin AI tarafından üretildiğini açıkça söyle

(Şeffaflık güven yaratır. Küçük bir “Yapay zekâ desteğiyle üretildi” etiketi bile yeterli.) - Kararsızlığa düşen kullanıcıya öneri sun

(“Sonraki adım ne olabilir?” sorusunu kullanıcıya sormadan, seçeneklerle yanıt ver.) - Kaynak göster

(Özellikle metin üretiminde. “via Cohere” gibi minik notlar bile güven sağlar.) - Gecikmeyi hissettirme, ama durumu açıkla

(Yanıt gecikiyorsa, animasyon ya da ilerleme çubuğuyla “beklettiğini” kabul et.) - Geri bildirime açık kal

(Küçük bir thumbs up / thumbs down simgesi bile yeter. Kullanıcı kendini dahil hisseder.)

Yeni nesil UX Yaklaşımları

Semantic Zoom

UX artık sadece görünür metni düzenlemek değil, metnin katmanlarını tasarlamakla da ilgili. Maeda verdiği örnekte, kullanıcı bir paragrafı parmakla yakınlaştırma yeni detaylar açılıyor. Tıpkı haritalarda yakınlaşınca sokak isimlerini görmemiz gibi. Bu yaklaşım, gelecekte içerik odaklı ürünlerde yepyeni deneyimlerin önünü açabilir. Gizli bilgiyi saklamak değil, doğru anda görünür kılmak artık UX’in yeni görevi olabilir.

semantic pinch to zoom pic.twitter.com/SrZoDvBuu3

— harley turan (@hturan) April 5, 2024

Bu konular ilginizi çekiyorsa mutlaka yapay zekâ ile etkileşimde yeni yaklaşımlar konusunda Y Combinator + Raphael Schaad‘ın aşağıdaki videosunu izleyin.

- Yapay zekâya sadece ne yapacağını değil, neyi referans alarak yapacağını, neye göre bu cevabı üretmesi gerektiğini belirtilmeli. Bu referanslar bazen bir dosya adı, bazen önceki mesajlar, bazen de işin amacı olabilir.

- Sürüm kontrolü AI ile içerik üretimi çağında çok önemli. Bir kez üretmeye başladığında, 50 sürüm üretiyorsun. Sonra o 50’den 100 tane daha… Hangi sürüm iyi, hangisi değil? Bu başlı başına bir versiyon kontrolü problemi. Belki de “en iyi sürüm”ü yapay zekâ değil, kullanıcılarla birlikte seçen sistemler belirleyecek.

- Görsel model tarafında ise John Maeda, Pablo Stanley’nin X’te paylaştığı örneği öne çıkarıyor.

Kullanıcı yazı yazarak kendini anlatmak yerine, soyut ile gerçekçi, minimal ile maksimal arasında geçiş yaparak sezgisel yönlendirme ile şekillendiriyor.

What if users could adjust an image’s style, shifting between abstract and realistic + minimalist and maximalist, all while maintaining the same structure? @lummipics pic.twitter.com/jvcGll9kVH

— Pablo Stanley (@pablostanley) December 4, 2024

- Google’ın “Whisk pattern” adını verdiği yeni UX yaklaşımını boşluk doldurma cümle oyununa benzetiyor. Kullanıcılar, boşlukları doldurarak AI’ye yön veriyor. Bu “puzzle prompting” yöntemi, hem üretkenliği artırıyor hem de prompt yazma yükünü hafifletiyor.

BREAKING 🚨: Google released Whisk experiment this allows you to combine objects from different images into one and refine it further 👀

— TestingCatalog News 🗞 (@testingcatalog) December 16, 2024

Codeneme “backbone”. It is available on Google Labs already. pic.twitter.com/XMkm7Y1rmy

- Görsel üretimde, Recraft gibi sistemler sayesinde, kullanıcılar çok daha ince ayarlı tercihler yapabiliyor:

Renk tonu, ışık açısı ihtiyaçların hepsi sürükle-bırak ya da tıkla-seç arayüzleriyle mümkün. John Maeda bu deneyimi “fine-grained prompting” olarak tanımlıyor — yani AI’ye sanat yönetmeni gibi davranmak… Logoyu biraz büyütelim lütfen 😉 - Uygulamalar / programlar parçaları değiştirilebilen, farklı sistemlerle karıştırılıp yeniden tasarlanabilen, kullanıcının ihtiyaçlarına göre yeniden şekil alabilen bir yapıya dönüşüyor (Malleable Software)

in a world where new ui can be generated in real time pic.twitter.com/Q907eOThUV

— xavier (@atlou_) February 9, 2025

AI Arayüzleri 4 Farklı Alana Ayrılıyor

Maeda, yapay zekâ destekli arayüzlerin dört farklı çalışma alanına ayrıldığını söylüyor:

- Chat: İnsan gibi susabilen, düşünebilen botlar. Yapay zekâ sohbet arayüzleri, artık yalnızca “soru sor, cevap al” sistemlerinden çıkıyor. Bu alanda AI artık sadece yanıt veren değil, ne istediğimizi anlayan ve buna göre davranan bir sistem haline geliyor.

“Can you form a snowman?” A simple canvas for human + AI co-manipulation. 🔴🟢🔵💬 Made using Gemini 2.0 w/ @hapticdata. Video has sound 🔊. Prompt + thoughts in 🧵 pic.twitter.com/eclfd4SxeG

— Alexander Chen (@alexanderchen) January 10, 2025 - Dokümanlar: Tablolar artık semantik hale geliyor. Her hücre, içeriğe göre davranış sergileyebiliyor. Yani belgeler artık sadece okunmuyor; etkileşiyor, bağ kuruyor.

so you have a planning doc for an upcoming trip…

— Geoffrey Litt (@geoffreylitt) September 22, 2024

what if you could look up driving times between key locations, without switching to a separate app? pic.twitter.com/R09wxqdMhj - Tablolar: Geleneksel tablolar sadece sayı ve metinle çalışırken, yeni nesil yapay zekâ destekli tablolar anlamı da işliyor.

- Canvas: Sınırları belli olan ekranlar yerine, sonsuz genişlikte düşünme ve yaratım alanları ile sınırlar kalkıyor.

Navigating the Component Tree (2078) pic.twitter.com/qXRCLWCldJ

— Samuel Timbó (@io_sammt) March 6, 2025

✨ what if we could organize our emails on a canvas?

— Amelia Wattenberger 🪷 (@Wattenberger) September 17, 2024

actually going to do this for my Todos category to help it be less overwhelming! pic.twitter.com/52wFmXQIJt

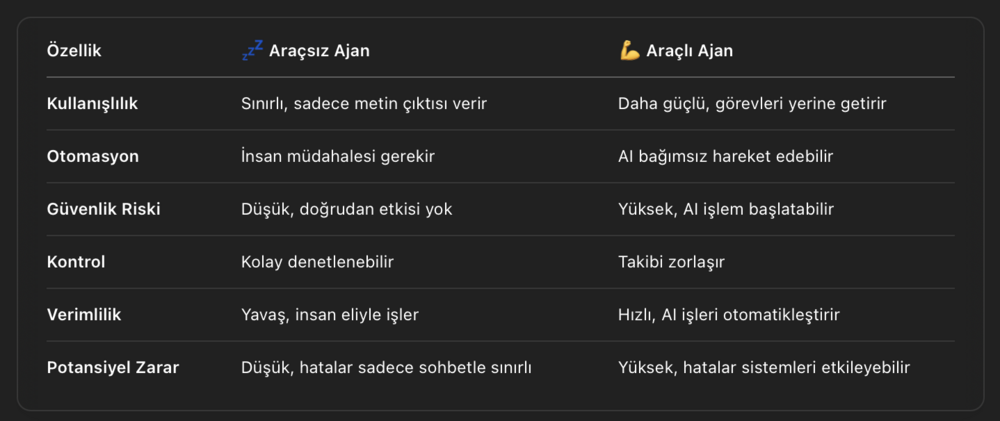

Araçlar, yapay zekâya güç katar — ama riski de artırır.

John Maeda’nın ifadesiyle: Araçsız (sadece kendi sisteminde çalışan) bir yapay zekâ uykuda gibidir. Yapay zeka sistemlerine araçlar tanımladığımızda (farklı platformlarla konuşmasına olanak sağlandığında), onların kapasitesini artırmış oluruz. Araç verdiğinizde güçlü olur ama tehlikeli de olabilir. Bu nedenle risk alarak ama planlı şekilde ilerlemek gerekiyor.

- John Maeda, yapay zeka model gelişimini en iyi anlatan örneklerden birini sesli metin okuma teknolojisinde buluyor. Apple’ın yıllar içindeki iOS sürümlerinde aynı cümlenin farklı şekillerde okunması, AI modellerinin ne kadar hızlı geliştiğini net şekilde ortaya koyuyor:

2015’te bir makine konuşuyordu; şimdi ise neredeyse bir insan. Sesame.com sesli AI asistanını mutlaka denemelisiniz. Gerçek biri ile konuşuyormuş gibi hissediyorsunuz. - Robotlar Geliyor!

Sunumun bu kısmında Maeda, yapay zekânın ve robotların yalnızca teoride değil, pratikte de hayatımıza girdiğini örneklerle gösteriyor. 2006’da yapılmış kendi kendini toparlayan bir sandalye, Tokyo’daki “Doktor Ahtapot” tarzı kollar, Interstellar’daki TARS robotu ve insansı robot örneklerinden bir kaçı idi.

Protoclone, the world’s first bipedal, musculoskeletal android. pic.twitter.com/oIV1yaMSyE

— Clone (@clonerobotics) February 19, 2025

- Maeda, insanlar artık yapay zekalarla yalnızca bilgi almak için değil, sohbet etmek, arkadaşlık kurmak veya yalnızlığı gidermek için etkileşimde bulunduğundan ve hayatımızda artık “yapay zeka dostları” ya da dijital dostlar”ın da olduğunu anlatıyor. Sohbet temelli yapay zekâlar, sihirli oldukları için değil; kullanıcıdan gelen içerikleri kullanarak “anlamlıymış gibi” görünen cevaplar ürettikleri için etkileyicidir. 1966 tarihli “psikolog chatbot” simülasyonu ELIZA çok basitti ama yanıtları tekrar ederek insanları etkileyebiliyordu.

Maeda’ın sunumunun tamamını aşağıdaki videoda izleyebilirsiniz.

Görsel: Youtube

![Yapay Zekayla Yeniden Tasarlanan Yaratıcılık [SXSW 2025]](https://bigumigu.com/wp-content/uploads/2025/04/ai_yaraticilik-1280x680.jpg)